Cos’è l’Intelligenza Artificiale e perché è utile alle aziende

Innovation

Technology

Consulting

Home » Cos’è l’Intelligenza Artificiale e perché è utile alle aziende

Cos’è l’Intelligenza Artificiale

La sua evoluzione è stata guidata da personaggi chiave che hanno contribuito a sviluppare nuove tecniche di apprendimento e a creare applicazioni innovative in diversi settori. Oggi, l’AI ha un impatto significativo sulla società e sull’economia, e il suo futuro sarà determinato dalla nostra capacità di affrontare le sfide etiche e sociali che essa pone.

Come possiamo aiutarti a implementarle e gestirla in azienda?

La nostra soluzione consente di sviluppare e attuare forme di Data Driven Innovation e/o AI Driven Innovation, grazie a un framework di supporto basato su cinque concetti potenti che, da soli, racchiudono il vero significato della trasformazione digitale basata sui dati: Conoscenza, Precisione, Responsabilità, Etica, Privacy.

L’obiettivo è quello di promuovere significativi miglioramenti interni e sviluppare una cultura dell’innovazione che possa durare a lungo all’interno dell’azienda promuovendo la sua competitività sul mercato.

Il nostro Framework dedicato all’adozione dell’Intelligenza Artificiale è composto da un insieme ben bilanciato di nostri strumenti e metodologie, mescolati con strumenti e metodologie aperti e/o standard de facto.

La Nostra Metodologia Proprietaria In 4 Fasi:

- Analizziamo lo stato attuale dell’azienda;

- Capiamo in che modo l’intelligenza artificiale possa aiutare la propria attività;

- Rappresentiamo e pianifichiamo strategie di adozione fattibili;

- Gestiamo il Cambiamento.

Aree Di applicazione della nostra consulenza operativa

- Automazione dei processi

l’IA può migliorare l’efficienza e ridurre i costi. - Analisi dei dati

Per analizzare grandi quantità di fati aziendali per identificare tendenze e modelli, aiutando le imprese a prendere decisioni informate. - Assistenza virtuale

I chatbot per fornire supporto ai clienti e migliorare l’esperienza del cliente. - Rilevamento delle frodi

Per migliorare la sicurezza e la protezione delle imprese rilevando frodi finanziarie. - Riconoscimento di immagini e di voce

Per velocizzare i processi e procedure aziendali ad esempio la trascrizione automatica delle conversazioni. - Personalizzazione del marketing

L’IA può essere utilizzata per migliorare l’efficacia delle campagne pubblicitarie. - Analisi dei sentimenti

Per aiutare le imprese a comprendere meglio le opinioni dei clienti, analizzando i sentimenti degli utenti sui social media e altri canali online. - Analytics conversazionale

Per analizzare conversazioni tra persone e tra persone e macchine e migliorare l’esperienza del cliente fornendo un supporto più efficace.

Ma torniamo a scoprire un po’ di storia dell’Intelligenza Artificiale!

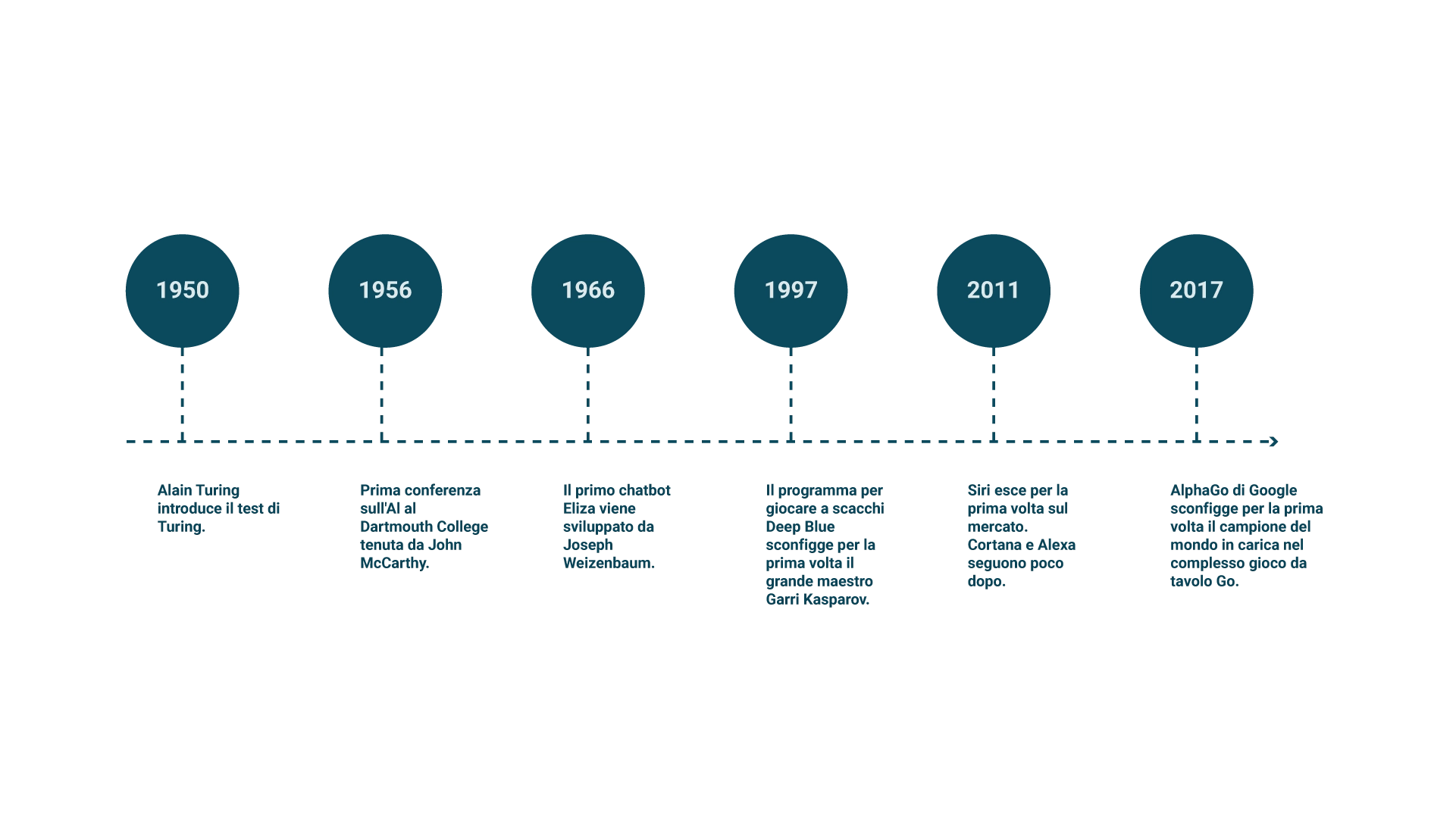

Com’è nata l’IA

Nei primi anni di sviluppo dell’AI, molti ricercatori erano ottimisti sulle potenzialità di questa tecnologia e credevano che sarebbe stato possibile creare macchine intelligenti in un lasso di tempo relativamente breve. Nel 1956, il matematico e informatico statunitense John McCarthy coniò il termine “Artificial Intelligence” durante la famosa Conferenza di Dartmouth, un evento che riunì alcuni dei più grandi esperti del settore e che viene considerato il punto di partenza dell’IA moderna.

Tra gli anni ’50 e ’60, l’AI conobbe una fase di crescita e sviluppo rapido, grazie a progressi nel campo delle reti neurali e dell’apprendimento automatico. Tra i personaggi chiave di questo periodo, ci furono Marvin Minsky e Seymour Papert, che fondarono il MIT AI Lab, un centro di ricerca dedicato all’AI che è ancora oggi uno dei più prestigiosi al mondo.

Tuttavia, a partire dagli anni ’70, l’IA attraversò un periodo di crisi e stagnazione, conosciuto come “IA winter“. Durante questo periodo, il progresso tecnologico rallentò e molti progetti di ricerca furono abbandonati a causa della mancanza di fondi e dell’insuccesso nel raggiungere gli obiettivi prefissati.

La rinascita dell’IA avvenne negli anni ’90, grazie a nuove tecniche di apprendimento, come le reti neurali a più strati e gli algoritmi di apprendimento profondo, che permisero alle macchine di apprendere in modo efficace e di svolgere compiti complessi. Tra i ricercatori di spicco di questo periodo ci furono Geoffrey Hinton, YannLeCun e Yoshua Bengio, i cosiddetti “padri del Deep Learning“. Questi studiosi hanno contribuito allo sviluppo delle reti neurali convoluzionali (CNN) e delle reti neurali ricorrenti (RNN), che hanno rivoluzionato il riconoscimento di immagini e la comprensione del linguaggio naturale.

Nel corso degli anni 2000 e 2010, l’IA ha continuato a evolversi rapidamente, grazie a progressi nella potenza di calcolo e alla disponibilità di enormi quantità di dati. Questo ha permesso lo sviluppo di nuove tecniche di apprendimento, come il Reinforcement Learning, che ha portato a importanti successi, come la vittoria del programma AlphaGo di DeepMind sul campione del mondo di Go, un risultato che ha sconvolto la comunità scientifica e dimostrato il potenziale dell’IA nel risolvere problemi estremamente complessi.

Oggi, l’IA è parte integrante di molte tecnologie che utilizziamo quotidianamente, come i motori di ricerca, gli assistenti virtuali (ad esempio, Siri e Alexa) e le piattaforme di raccomandazione (come Netflix e Amazon). Inoltre, l’IA sta trovando applicazioni in settori come la medicina, finanza, industria e trasporti, con un impatto sempre maggiore sulla società e sull’economia.

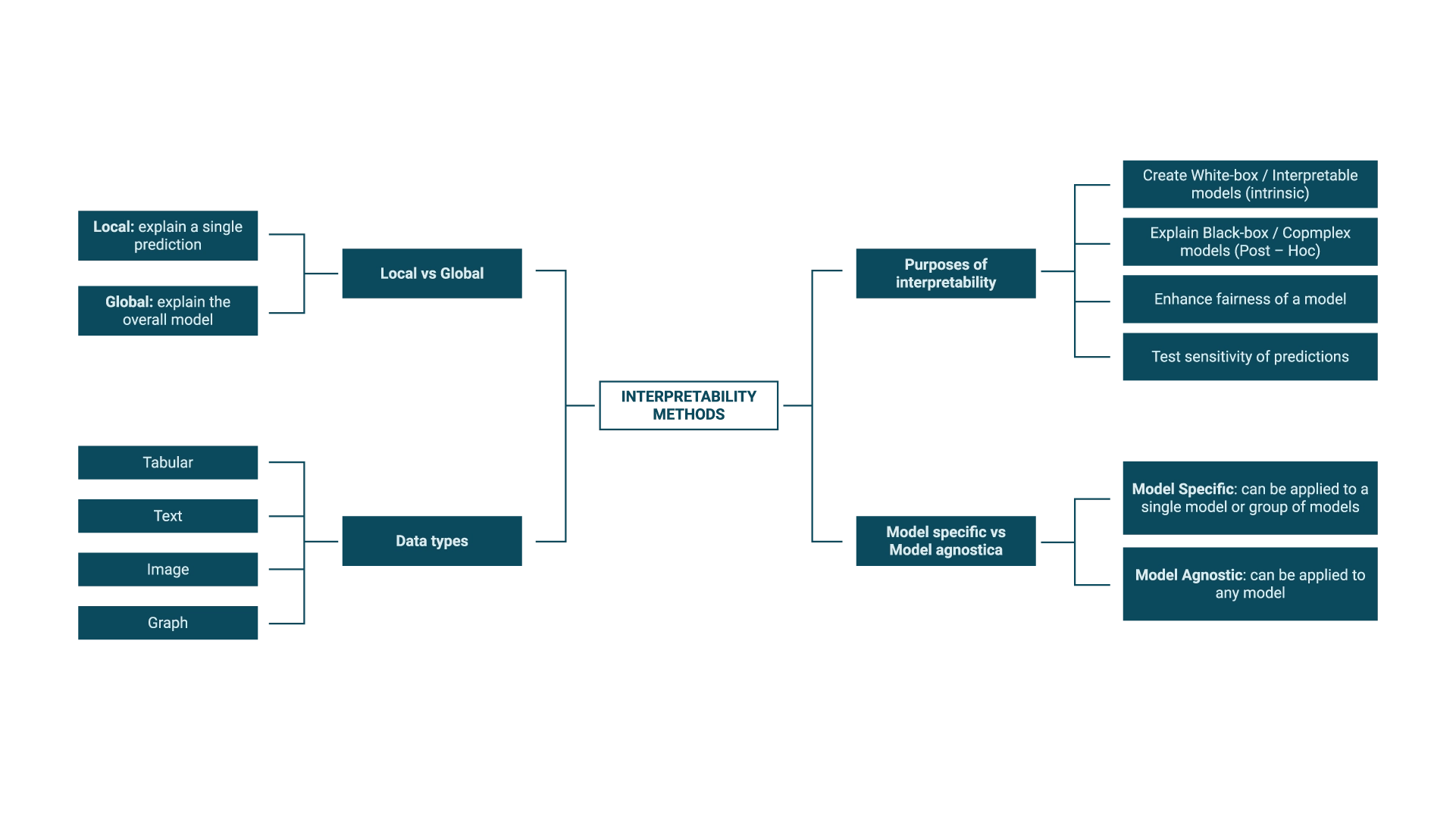

Tuttavia, l’evoluzione dell’IA pone anche sfide etiche e sociali che richiedono un dibattito aperto e una riflessione approfondita. Tra le principali preoccupazioni, vi sono la protezione della privacy, la discriminazione algoritmica e la perdita di posti di lavoro a causa dell’automazione. Il futuro dell’IA prevede una grande attenzione nei confronti di questi temi – inclusi nella cosiddetta Explainable Artificial Intelligence – e dipenderà dalla nostra capacità di affrontare queste sfide e di garantire uno sviluppo sostenibile e responsabile della tecnologia.

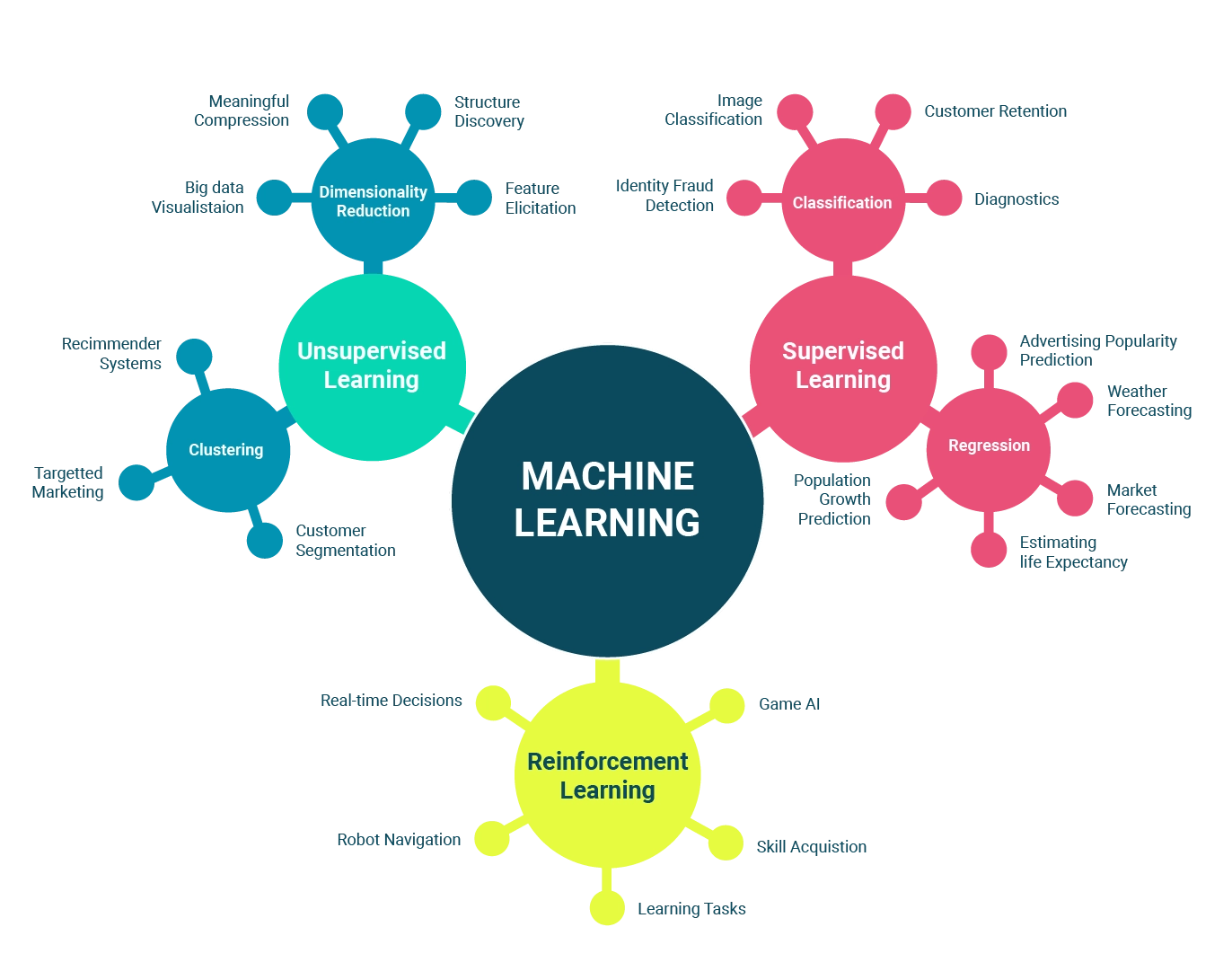

Il Machine Learning: un approccio all’IA

Esistono tre tipi principali di Machine Learning:

- Apprendimento supervisionato: il sistema viene addestrato su un insieme di dati etichettati, imparando a prevedere le etichette per nuovi dati. Questo tipo di apprendimento è comunemente utilizzato per la classificazione e la regressione. Alcuni esempi di applicazioni specifiche includono:

- Riconoscimento facciale: identificazione di persone in base alle loro caratteristiche facciali.

- Diagnostica medica: prevedere la presenza di malattie basandosi su esami e dati dei pazienti.

- Filtri antispam: identificazione delle email indesiderate in base a caratteristiche specifiche.

- Apprendimento non supervisionato: il sistema cerca di scoprire schemi o strutture nascoste nei dati senza etichette predefinite. Questo approccio è spesso utilizzato per il raggruppamento e la riduzione della dimensionalità dei dati. Alcuni esempi di applicazioni specifiche sono:

- Segmentazione del mercato: identificazione di gruppi di consumatori con caratteristiche simili per personalizzare le strategie di marketing.

- Analisi delle reti sociali: identificazione di comunità all’interno delle reti sociali basandosi sulla struttura delle connessioni tra gli utenti.

- Detezione di anomalie: rilevamento di comportamenti insoliti o sospetti in sistemi complessi come la sicurezza informatica o la manutenzione predittiva.

- Apprendimento per rinforzo: il sistema apprende attraverso l’interazione con l’ambiente, ricevendo riscontri positivi o negativi. In questo caso, l’obiettivo è trovare la strategia ottimale per massimizzare la ricompensa nel lungo termine. Alcune applicazioni specifiche di questo tipo di apprendimento includono:

- Robotica: addestramento di robot per eseguire compiti complessi, come il controllo di un braccio robotico o la navigazione in ambienti sconosciuti.

- Giochi: addestramento di agenti intelligenti per giocare a giochi come scacchi, Go e videogiochi.

- Ottimizzazione di sistemi energetici: regolazione dell’uso e della distribuzione di energia in reti elettriche per massimizzare l’efficienza energetica.

Applicazioni pratiche dell’IA

L’intelligenza artificiale ha rivoluzionato numerosi settori, migliorando le prestazioni e ottimizzando i processi in modi prima inimmaginabili. Di seguito sono elencate alcune delle aree più influenzate dall’AI, con descrizioni più ampie e un riferimento bibliografico per ulteriori approfondimenti:

- Assistenti virtuali: Siri, Alexa e Google Assistant sono alcuni esempi di assistenti virtuali che utilizzano il Processamento del Linguaggio Naturale (NLP) per comprendere e rispondere alle domande degli utenti in modo efficace e naturale. L’NLP ha permesso un’interazione più intuitiva tra gli utenti e i dispositivi, rendendo più semplice l’accesso alle informazioni e la gestione delle attività quotidiane (Hirschberg & Manning, 2015).

- Medicina: L’IA ha trasformato il settore sanitario attraverso la diagnosi precoce delle malattie, la personalizzazione delle terapie e la scoperta di nuovi farmaci. Ad esempio, gli algoritmi di apprendimento profondo sono stati utilizzati per rilevare anomalie nelle immagini mediche, come il cancro al seno e il melanoma, con una precisione paragonabile a quella degli esperti umani (Esteva et al., 2017).

- Trasporti: L’IA ha contribuito all’introduzione di veicoli autonomi e sistemi intelligenti di gestione del traffico. Queste tecnologie hanno ridotto gli incidenti stradali e migliorato l’efficienza energetica, oltre a ridurre i tempi di viaggio e l’inquinamento atmosferico. Un esempio di successo in questo campo è il progetto di auto a guida autonoma di Google, Waymo (Bishop, 2018).

- Industria: L’impiego di robot e sistemi di automazione basati sull’AI ha permesso un aumento della produttività e una riduzione dei costi operativi nelle catene di montaggio e nei processi produttivi. L’intelligenza artificiale ha inoltre consentito una migliore manutenzione predittiva e la creazione di catene di fornitura più resilienti (Lu et al., 2017).

Finanza: Gli algoritmi di trading e analisi predittiva basati sull’IA sono stati utilizzati per migliorare le decisioni di investimento e la gestione del rischio. L’IA può analizzare grandi quantità di dati storici e in tempo reale per individuare tendenze e opportunità di investimento, offrendo un vantaggio competitivo rispetto ai metodi tradizionali (Dixon et al., 2020).

Il futuro dell’IA

Evoluzione della tecnologia IA

Le recenti innovazioni nel campo dell’intelligenza artificiale hanno portato a notevoli progressi nella capacità di elaborazione e nelle prestazioni dei sistemi IA. Innovazioni chiave come il Deep Learning, il Reinforcement Learning e il Transfer Learning hanno rivoluzionato l’ambito dell’IA e spianato la strada a una nuova era di applicazioni e progressi tecnologici. In questo contesto, si prevede che gli sviluppi futuri riguarderanno principalmente la comprensione del linguaggio naturale, la visione artificiale e la generazione di contenuti.

- Comprensione del linguaggio naturale (NLP): L’NLP è un settore in rapida evoluzione che mira a migliorare la comunicazione tra le macchine e gli esseri umani. Con l’avvento di modelli di linguaggio avanzati come GPT-3 di OpenAI, si prevede che i progressi nell’NLP porteranno a interazioni più naturali e sofisticate tra utenti e sistemi IA. Inoltre, l’NLP avrà un impatto notevole sulla generazione di contenuti, sull’analisi dei sentimenti e sulle applicazioni di traduzione automatica.

- Visione artificiale: La visione artificiale è un altro campo in rapida crescita, con progressi significativi nella capacità delle macchine di riconoscere e interpretare immagini e video. Grazie al Deep Learning e a tecniche come le reti neurali convoluzionali (CNN), si stanno compiendo importanti passi avanti nella segmentazione delle immagini, nel riconoscimento di oggetti e nello sviluppo di sistemi di intelligenza artificiale in grado di “vedere” il mondo come gli esseri umani. Questo progresso potrebbe portare a un’ampia gamma di applicazioni, dalla guida autonoma alla diagnosi medica assistita da IA.

- Generazione di contenuti: La generazione di contenuti tramite IA sta guadagnando sempre più terreno, con la creazione di testi, immagini, video e audio di alta qualità attraverso l’uso di algoritmi avanzati. Ad esempio, i Generative Adversarial Networks (GAN) sono stati utilizzati per generare immagini e video realistici, aprendo nuove opportunità nell’industria dell’intrattenimento e della pubblicità.

Tra i centri di ricerca pubblici e privati più promettenti nel campo dell’IA, possiamo annoverare:

- OpenAI: Fondata da Elon Musk, Sam Altman e altri imprenditori di spicco, OpenAI si dedica alla ricerca e allo sviluppo di intelligenza artificiale avanzata e sicura, con l’obiettivo di garantire che i benefici dell’IA siano condivisi da tutta l’umanità.

DeepMind: Acquisita da Google nel 2014, DeepMind è nota per lo sviluppo di algoritmi di Reinforcement Learning come AlphaGo e AlphaZero, che hanno sconfitto i campioni mondiali in giochi complessi come Go e scacchi.

Impatti sociali ed etici dell’IA

Come abbiamo visto, l’intelligenza artificiale ha portato a notevoli progressi in vari settori, ma è fondamentale garantire che il suo impiego sia responsabile e i benefici siano condivisi equamente. I principali temi etici e sociali riguardano l’inclusione, il superamento dei bias etici e la protezione dei dati.

- Inclusione: La riduzione del divario digitale e l’accesso equo alle tecnologie IA sono cruciali per garantire che tutti possano trarre vantaggio dai progressi dell’IA. Ciò implica migliorare la formazione, l’istruzione e l’accesso alle infrastrutture digitali, specialmente nelle comunità svantaggiate e in via di sviluppo. Inoltre, è importante garantire che le persone con disabilità possano beneficiare delle tecnologie IA, ad esempio, attraverso lo sviluppo di dispositivi di assistenza e interfacce accessibili.

- Bias etici: Gli algoritmi di IA possono incorporare e perpetuare pregiudizi e discriminazioni presenti nei dati su cui sono addestrati, portando a risultati iniqui e disuguaglianze. Per affrontare questo problema, è necessario promuovere la ricerca e lo sviluppo di algoritmi imparziali e responsabili che tengano conto delle implicazioni etiche. Inoltre, è essenziale incoraggiare la diversità e l’inclusione tra i ricercatori e gli sviluppatori di IA, per garantire che diverse prospettive siano rappresentate nello sviluppo di queste tecnologie.

- Protezione dei dati: La raccolta e l’analisi di enormi quantità di dati personali da parte delle aziende e delle organizzazioni che utilizzano l’IA sollevano preoccupazioni sulla privacy e sulla sicurezza dei dati. È fondamentale stabilire e far rispettare standard di protezione dei dati e normative sulla privacy che garantiscano il controllo degli utenti sui propri dati e la responsabilità delle organizzazioni che li gestiscono.

Altre considerazioni riguardano l’impatto dell’IA sul mercato del lavoro e sulle competenze richieste IA lavoratori. L’automazione e l’IA possono causare la scomparsa di alcuni lavori e la creazione di nuove opportunità lavorative, richiedendo una riconversione delle competenze e un adattamento dei sistemi educativi e di formazione professionale.

In sintesi, per affrontare gli impatti sociali ed etici dell’IA, è necessario un approccio olistico che promuova l’inclusione, combatta i bias etici e garantisca la protezione dei dati, oltre a preparare la forza lavoro per le sfide e le opportunità emergenti.

L’Intelligenza Artificiale e il Machine Learning stanno trasformando il nostro mondo in modi sorprendenti e imprevedibili. Grazie alle loro potenti capacità di apprendimento e adattamento, questi sistemi stanno cambiando il modo in cui lavoriamo, comunichiamo e risolviamo problemi complessi. Mentre continuiamo a esplorare e sfruttare il potenziale di queste tecnologie, è essenziale che lo facciamo in modo responsabile e attento alle sfide etiche e sociali che ci attendono.

Fonti

- Crawford, K., & Calo, R. (2016). There is a blind spot in AI research. Nature, 538(7625), 311-313.

- O’Neil, C. (2016). Weapons of math destruction: How big data increases inequality and threatens democracy. Broadway Books

Riferimenti bibliografici:

- Bishop, R. (2018). Autonomous vehicles and the law: Technology, algorithms, and ethics. Edward Elgar Publishing.

- Dixon, M., Klabjan, D., & Siolas, G. (2020). Artificial intelligence in finance. Academic Press.

- Esteva, A., Kuprel, B., Novoa, R. A., Ko, J., Swetter, S. M., Blau, H. M., & Thrun, S. (2017). Dermatologist-level classification of skin cancer with deep neural networks. Nature,

Indice

Iscriviti alla newsletter

Indice

Iscriviti alla newsletter

Ottieni maggiori informazioni

Compila il modulo per metterti in contatto con noi. Saremo lieti di rispondere a tutte le tue domande.

Home » Cos’è l’Intelligenza Artificiale e perché è utile alle aziende