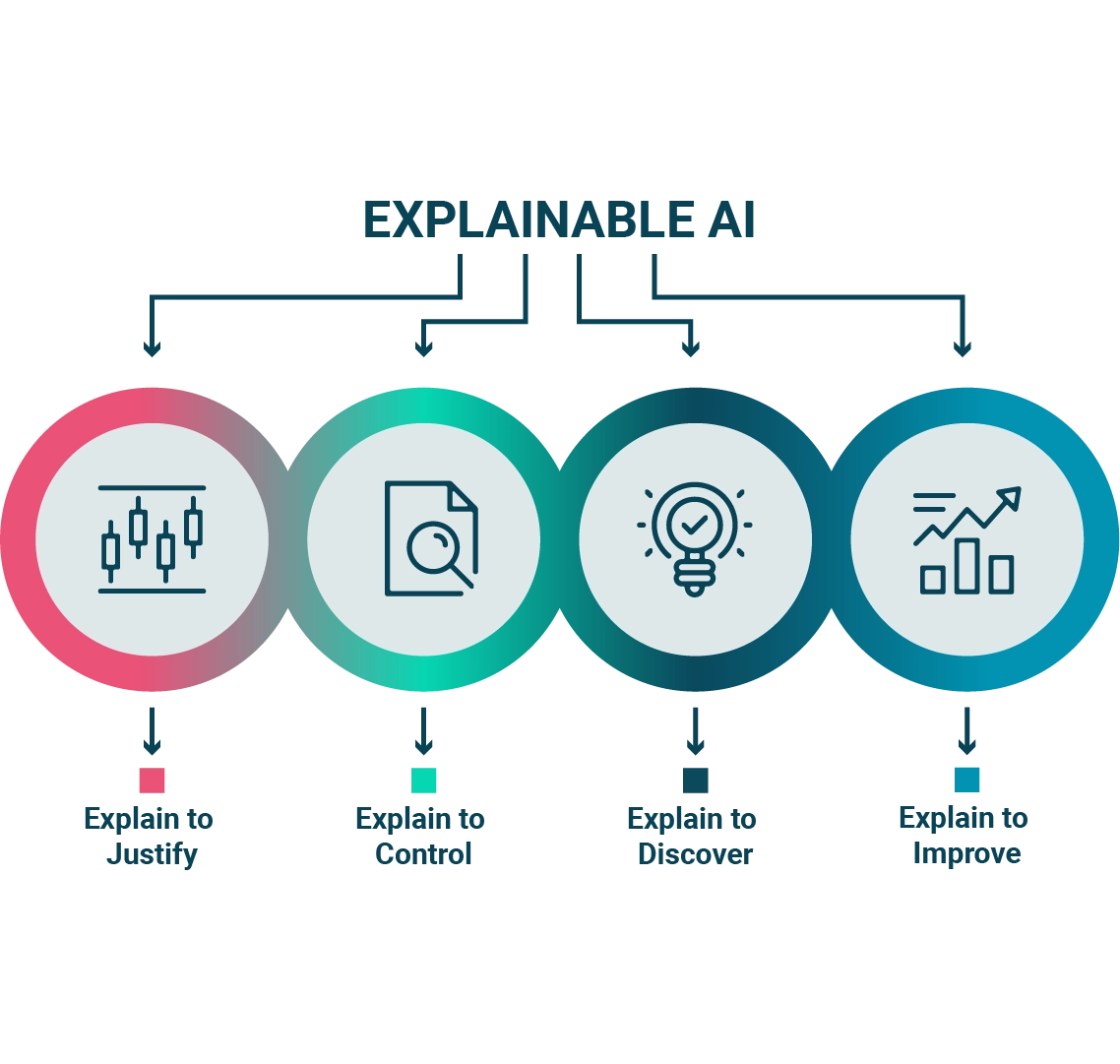

L'IA è sempre più presente nella vita di tutti i giorni: la troviamo nei nostri cellulari, in casa e in molti dei sistemi che usiamo quotidianamente. Tuttavia, molte persone sono ancora diffidenti riguardo l'adozione dell'IA, a causa della mancata comprensione delle decisioni che prende. In Frontiere siamo convinti che l’intelligenza artificiale non debba sostituire l’essere umano ma aumentarne le capacità, e l'Explainable AI va esattamente in questa direzione.

Si tratta di una tecnologia emergente che mira a risolvere questo problema fornendo una spiegazione di come l'IA ha raggiunto una determinata decisione. Andiamo quindi a capire come l'XAI può superare le perplessità riguardo all'adozione dell'IA e come può aiutare a rendere questa tecnologia più chiara.

L'XIA presenta diversi vantaggi:

L'XAI utilizza diverse tecniche per fornire una spiegazione di come l'IA ha raggiunto una determinata decisione. Alcune di queste tecniche includono:

L'XIA ha numerose applicazioni in vari settori. Alcune di queste applicazioni includono:

Nonostante i numerosi benefici, esistono anche alcune limitazioni. Alcune di queste includono:

In conclusione, l'Explainable IA può aiutare a superare le diffidenze riguardo all'adozione dell'IA. L'XIA può rendere il processo decisionale dell'AI più trasparente, aumentare la fiducia delle persone nell'IA e migliorare l'affidabilità dell'IA. Inoltre, l'XAI ha numerose applicazioni in vari settori. Tuttavia, ci sono anche alcune limitazioni che devono essere prese in considerazione. Nonostante ciò, l'XAI rappresenta un importante passo avanti nell'adozione dell'IA e potrebbe avere un impatto significativo sulla nostra vita quotidiana.